Hardware di un robot umanoide

Il nostro Piccolo Paul teacher, non è solo software ed intelligenza artificiale, ma è realizzato da un hardware altamente professionale che risponde in modo efficace agli input esterni.

Per il nostro progetto Piccolo Paul utilizza il robot umanoide Pepper prodotto dalla Aldebaran un’unità della SoftBank Robotics Group. Pepper è il primo robot umanoide al mondo in grado di identificare i volti e le principali emozioni umane. Progettato per interagire con gli esseri umani nel modo più naturale possibile attraverso il dialogo, il touch screen e i diversi sensori, capace catturare l'attenzione ed esprimere sentimenti mediante i led luminosi presenti negli occhi.

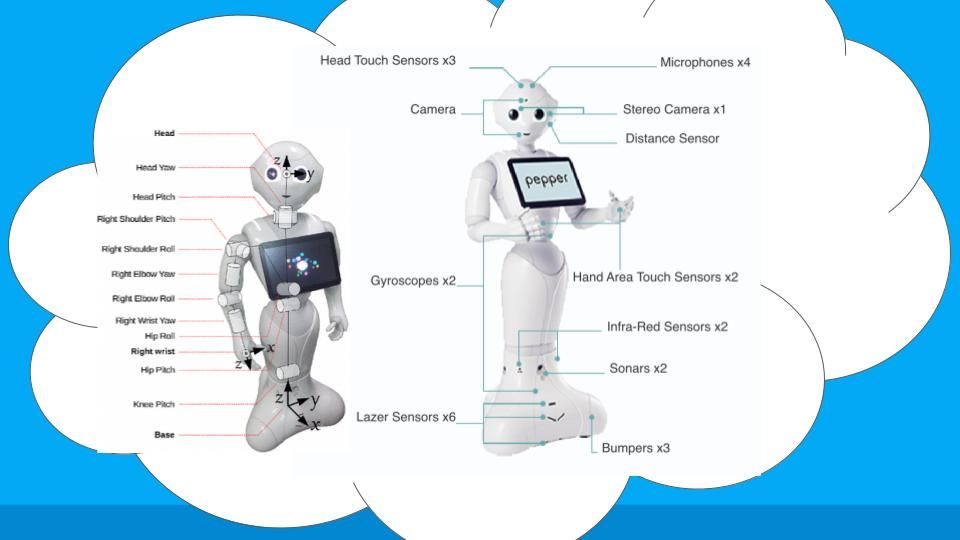

I sensori utilizzati su Piccolo Paul

Ogni sensore ha un ruolo chiave nelle funzionalità del robot, permettendogli di interagire in modo più intelligente e adattivo con il mondo esterno.

L'immagine illustra i diversi sensori presenti sul robot.

- Sensori tattili sulla testa (Head Touch Sensors) x3: Questi sensori permettono al robot di rilevare il contatto fisico. Possono essere utilizzati per la comunicazione con gli utenti, come il richiamo dell'attenzione o la risposta a un tocco gentile.

- Microfoni x4: Posizionati in modo strategico per rilevare il suono da diverse direzioni, i microfoni consentono al robot di ricevere comandi vocali e di localizzare la fonte del suono.

- Camera (fotocamera): Una fotocamera è installata per consentire al robot di riconoscere volti, oggetti e di leggere espressioni del viso, contribuendo all'interazione sociale.

- Stereo Camera x1: Questa coppia di fotocamere funziona in modo simile alla visione binoculare umana, consentendo al robot di percepire la profondità e di valutare la distanza degli oggetti.

- Sensore di distanza (Distance Sensor): Rileva la distanza tra il robot e gli oggetti circostanti per aiutare nella navigazione e l'evitamento degli ostacoli.

- Giroscopi x2: Sensore utilizzato per rilevare l'orientamento e l'equilibrio del robot, essenziali per la stabilizzazione durante il movimento.

- Sensori tattili sull'area della mano (Hand Area Touch Sensors) x2: Simili ai sensori tattili sulla testa, questi sensori nelle mani permettono al robot di rilevare quando viene toccato o quando afferra qualcosa.

- Sensori a infrarossi (Infra-Red Sensors) x2: Utilizzati per misurare la distanza tra il robot e gli oggetti, spesso impiegati in condizioni di scarsa luminosità o per rilevare il calore.

- Sonar x2: Questi sensori emettono onde sonore ad alta frequenza che rimbalzano sugli oggetti per determinarne la posizione, la distanza e la velocità relativa.

- Sensori laser (Lazer Sensors) x6: Usati per mappare l'ambiente circostante e rilevare ostacoli, contribuendo alla navigazione autonoma del robot.

- Paraurti (Bumpers) x3: Sensori meccanici che rilevano l'impatto fisico. Quando il robot urta contro qualcosa, i paraurti aiutano a identificare la collisione e a prevenire danni.